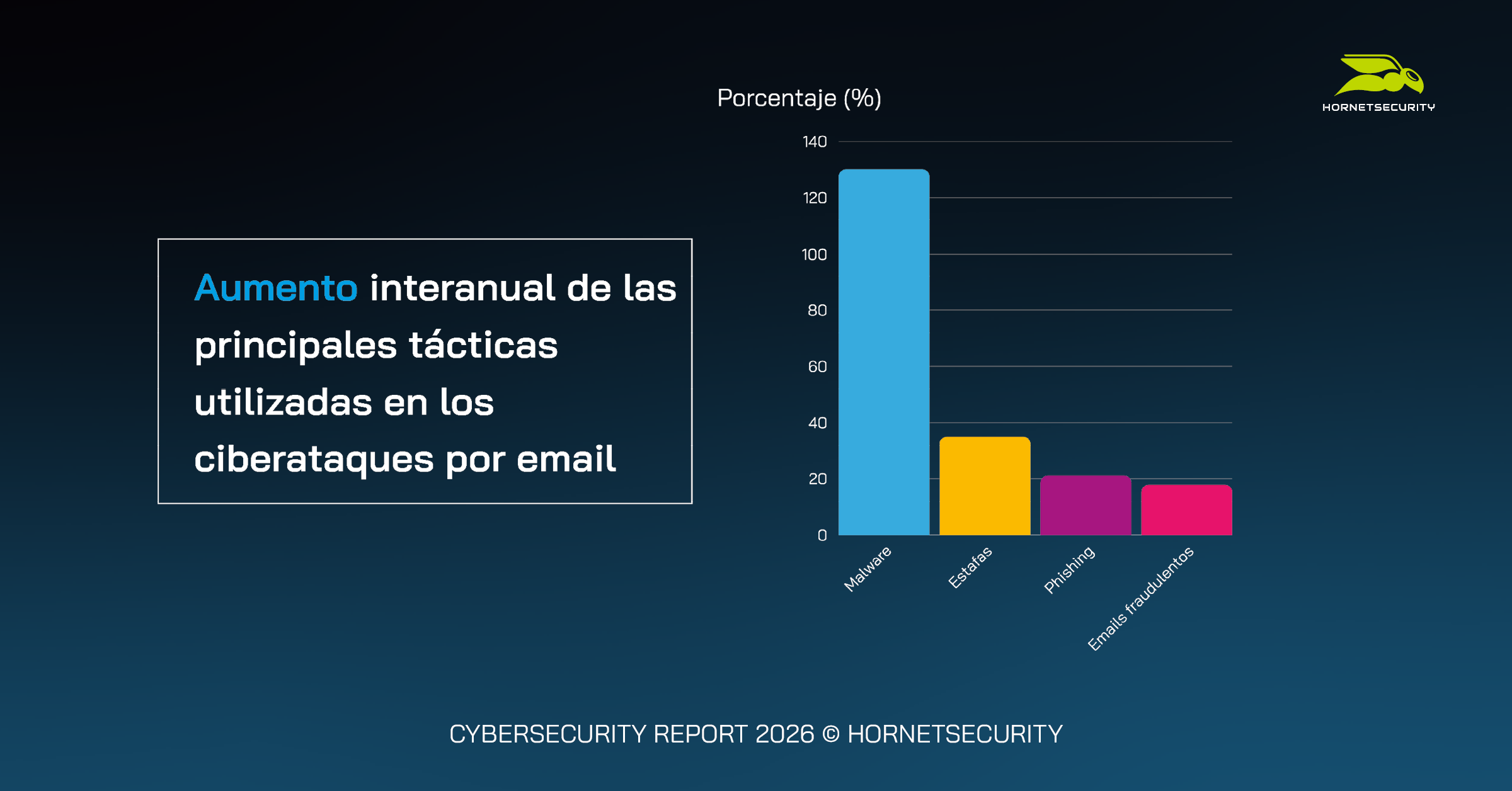

Los ataques de malware por correo electrónico han aumentado un 131% interanual, acompañados por un aumento en las estafas (+35%) y el phishing (+21%). Además, el 68% de las organizaciones ya ha invertido en 2025 en medidas de protección basadas en IA

El Cybersecurity Report, un estudio anual elaborado por el Hornetsecurity Security Lab tras revisar y analizar cerca de 72.000 millones de correos electrónicos, desvela que el correo electrónico ha sido un vector de entrada constante para los ciberataques en 2025. Los correos electrónicos cargados con malware aumentaron un 131% interanual y los ciberdelincuentes han podido crear contenidos fraudulentos más convincentes gracias a la IA generativa. De hecho, más de tres cuartas partes de los CISOs (77%) han identificado al phishing generado por IA como una amenaza grave y emergente, por lo que el 68% de las organizaciones han invertido ya este año en capacidades de detección y protección basadas en IA contra este tipo de amenazas.

El potencial del uso indebido de la IA se ha convertido en una tendencia clara. Así, según el estudio, el 61% de los CISOs cree que la IA ha aumentado directamente el riesgo de sufrir ataques de ransomware. Además, sus principales preocupaciones son el fraude de identidad sintética, que utiliza la IA para generar documentos y credenciales; la clonación de voz y los vídeos deepfake, para suplantar a usuarios; el ataque de poisoning, donde datos maliciosos corrompen los sistemas internos de IA; y el uso indebido de herramientas públicas de IA por parte de los empleados.

Otro factor importante a tener en cuenta es que los CISOs han percibido este año una gran disparidad en la comprensión de los riesgos relacionados con la IA por parte de los directivos de las empresas. Algunos informaron de que sus altos ejecutivos tenían una «profunda conciencia» de estas amenazas, pero otros admitieron que no tenían «ninguna comprensión real» del papel de la IA en este tipo de ataques. La respuesta media general indica que existe cierta conciencia, pero los avances eran inconsistentes y variaban mucho de una empresa a otra.

«Los resultados de nuestro estudio demuestran que las organizaciones están aprendiendo a recuperarse sin negociar. Pero los esfuerzos internos de concienciación sobre la seguridad deben evolucionar al mismo ritmo de la adopción de la IA. A medida que la desinformación impulsada por la inteligencia artificial y la extorsión realizada a través de deepfakes se vuelven más comunes, una cultura de seguridad basada en la preparación y respaldada por la concienciación sobre la IA, tendrá que ser un objetivo para 2026», señala Daniel Hofmann, CEO de Hornetsecurity.